全球知名人工智能企业OpenAI于10月29日宣布更新ChatGPT使用政策,明确禁止其在医学、法律和金融等高度专业化领域提供具体建议。

这一调整意味着,用户今后将无法通过ChatGPT获取医学影像解读、医疗诊断协助、法律意见或个性化的财务投资建议。

背景:合规与风险防控

据悉,此次政策收紧与欧盟《人工智能法案》(EU AI Act)及美国食品药品监督管理局(FDA)的相关指导要求密切相关。

OpenAI表示,限制措施旨在避免 AI 模型输出可能被视为“专业性、受托性或具有法律约束力”的内容,从而引发误导或责任纠纷。

换言之,ChatGPT将不再扮演“虚拟医生”“智能律师”或“理财顾问”的角色,而是引导用户寻求具备资质的人类专家。

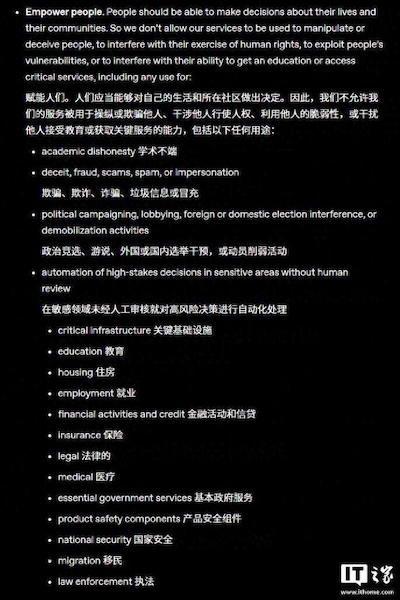

新政规定:人们应当能够对自己的生活和所在社区做出决定。因此,我们不允许我们的服务被用于操纵或欺骗他人、干涉他人行使人权、利用他人的脆弱性,或干扰他人接受教育或获取关键服务的能力,包括以下任何用途:

- 学术不端

- 欺骗、欺诈、诈骗、垃圾信息或冒充

- 政治竞选、游说、外国或国内选举干预,或动员削弱活动

- 在以下敏感领域未经人工审核就对高风险决策进行自动化处理:

- 关键基础设施

- 教育

- 住房

- 就业

- 金融活动和信贷

- 保险

- 法律

- 医疗

- 基本政府服务

- 产品安全组件

- 国家安全

- 移民

- 执法

用户反应:便利与风险的拉扯

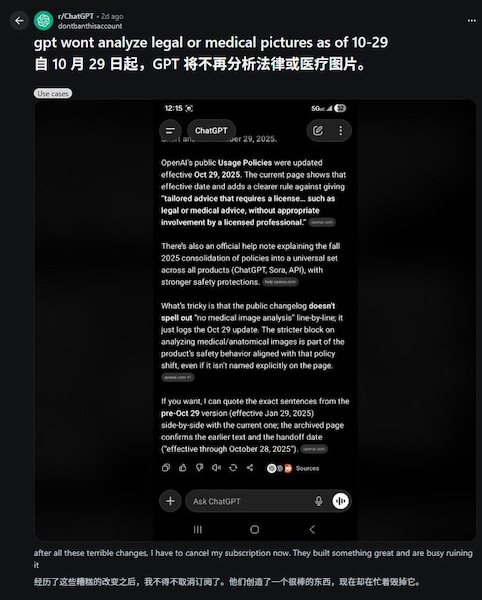

在社交平台Reddit上,不少用户对新规表达失望。

有网友直言:“经历了这些槽糕的改变之后,我不得不取消订阅了。他们创这了一个很棒的东西,现在却在忙着與施已。”

一位用户称:“ChatGPT在法律事务方面的表现非常出色,我从中受益良多,节省了大量费用。”

另一位用户则表示,ChatGPT曾在慢性病管理上给予了巨大帮助,“让我省下了不少不必要的就诊开销”。

然而,业内人士指出,AI提供的“非正式建议”虽便利,但若被误用,可能导致严重后果。尤其在医疗和法律领域,错误信息可能直接影响生命安全或法律权益。

专业人士的“防护盾”

有分析认为,此举实际上为医生、律师和金融顾问等专业人士设立了一道“职业防护盾”。

在AI技术快速发展的背景下,专业服务行业长期担心被低成本的智能工具取代。此次政策更新,或在一定程度上缓解了这种焦虑。

展望:垂直版AI的可能性

值得注意的是,新规并未阻止专业人士使用ChatGPT来辅助自身工作。

未来,市场或将出现针对医疗、法律、金融等领域的“专业版AI”,在严格监管和资质验证下,为持证从业者提供支持。

这次政策更新凸显了AI技术与社会规范之间的博弈。一方面,用户渴望低成本、高效率的智能服务;另一方面,监管与伦理要求则强调安全、责任与专业性。

简而言之,AI的边界正在被重新划定:它能做很多事,但并非所有事都该由它来做。

发表回复